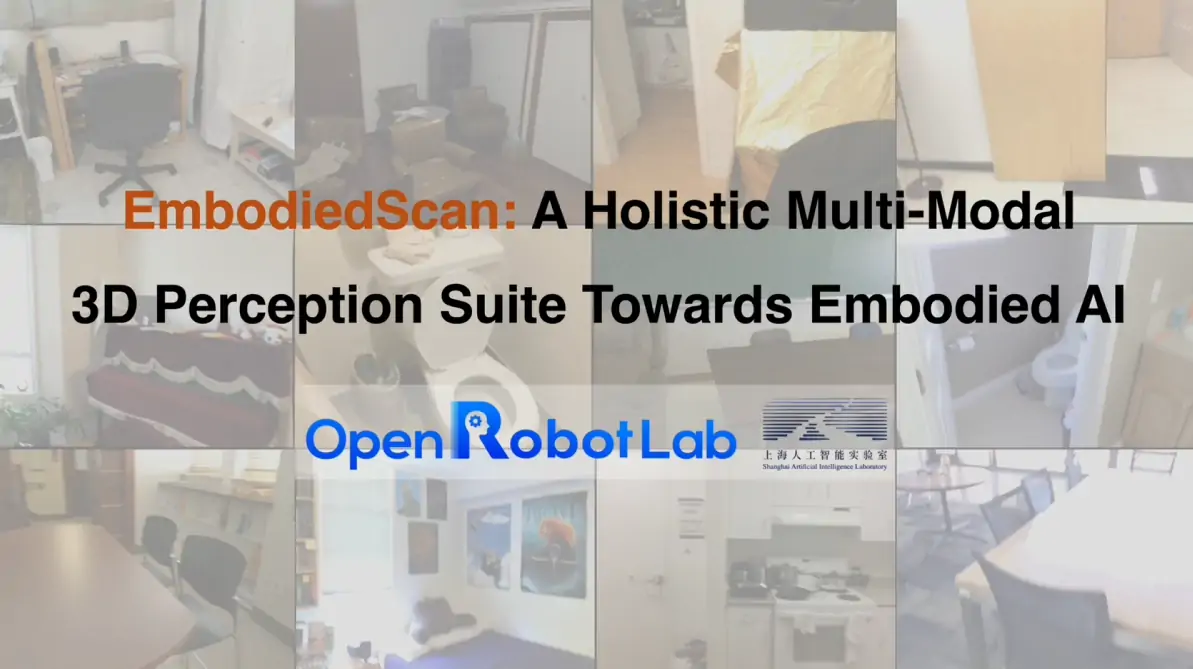

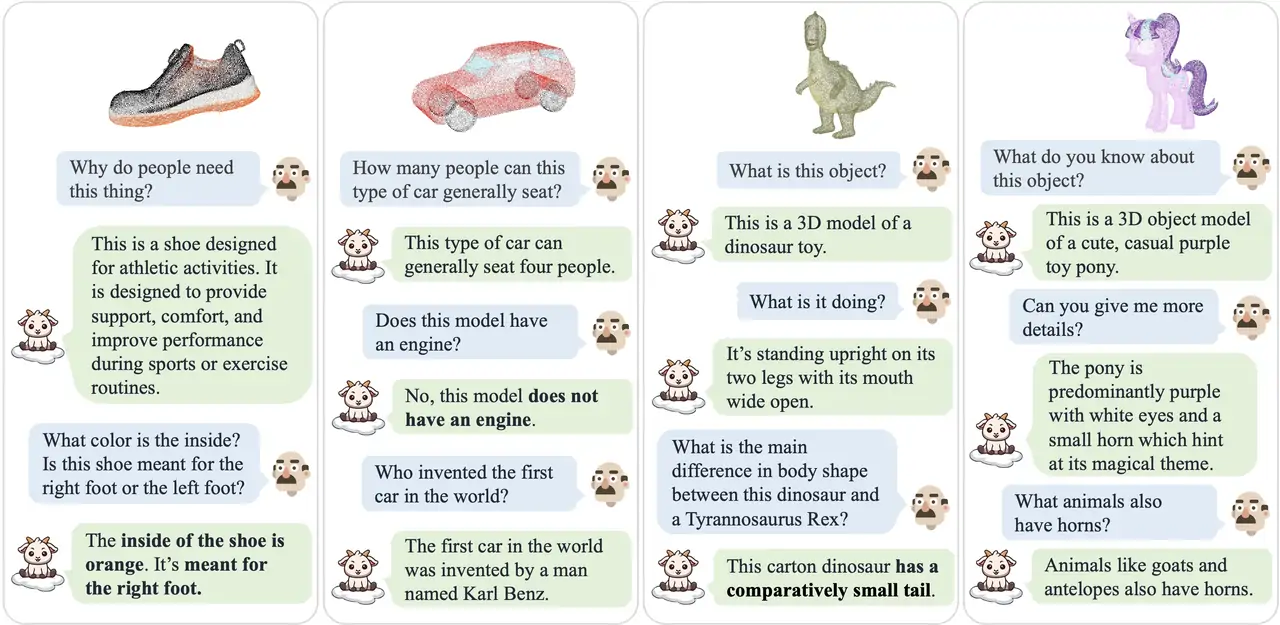

三维多模态感知与推理

3D Multi-modal Perception & Reasoning

基于大规模虚实混合场景资产,自动化构建海量多模态语料,配合人在回路或人工标注的高质量多元评测体系,持续推动从点云到第一视角图像输入的三维多模态大模型研究,让大模型具备通用的空间理解、想象、推理能力,构建数字空间到物理空间的感知桥梁

导航智能

技术报告Navigation Intelligence

基于自研的虚实贯通训练与评测管线,依托大规模数字场景资产与海量多模态语料,结合每日50000条轨迹/台天的数据合成效率,低成本高效率训练具备国际领先性能的导航“大脑”,“一脑多形”支持跨场景、跨本体的零样本泛化

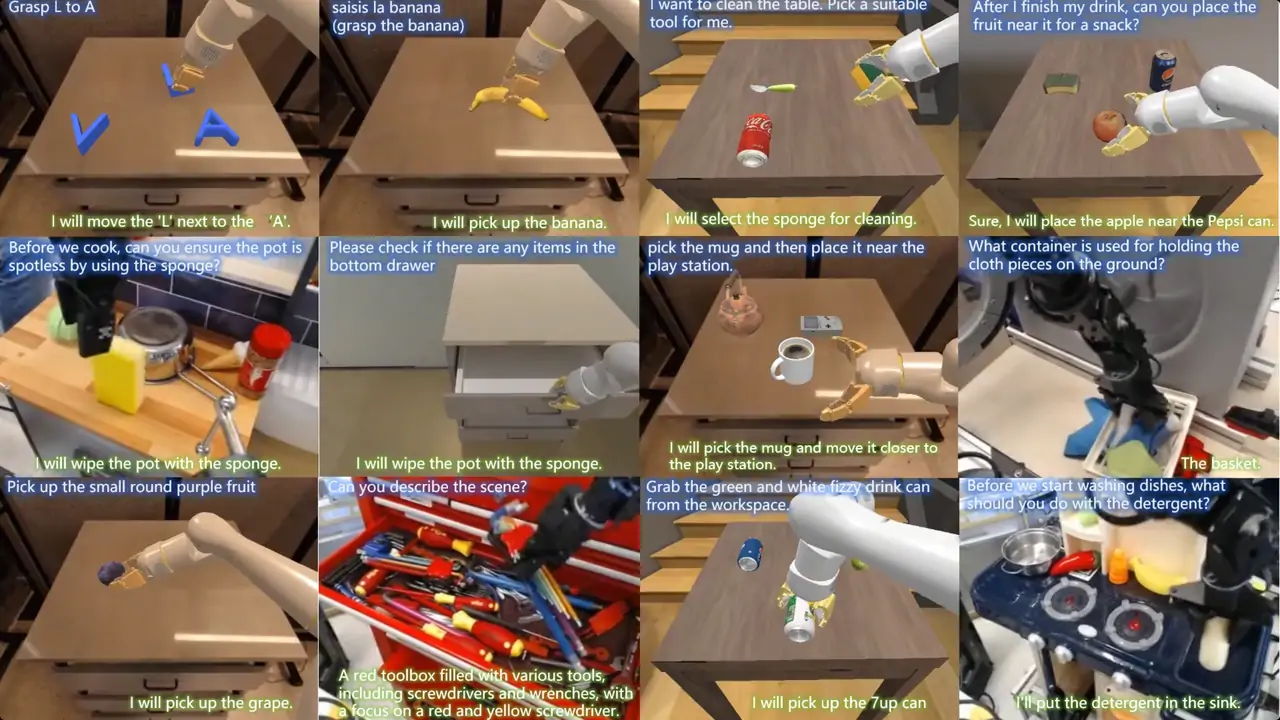

Manipulation Foundation Model

基于自研的虚实贯通训练管线,依托8万级语义标注的数字物体资产,并结合每日每台生成 8000 条轨迹的任务与动作规划一体化合成数据,赋能具身大脑复杂场景上指令跟随能力与跨任务泛化

操作智能

InternVLA-A1

Manipulation Foundation Model

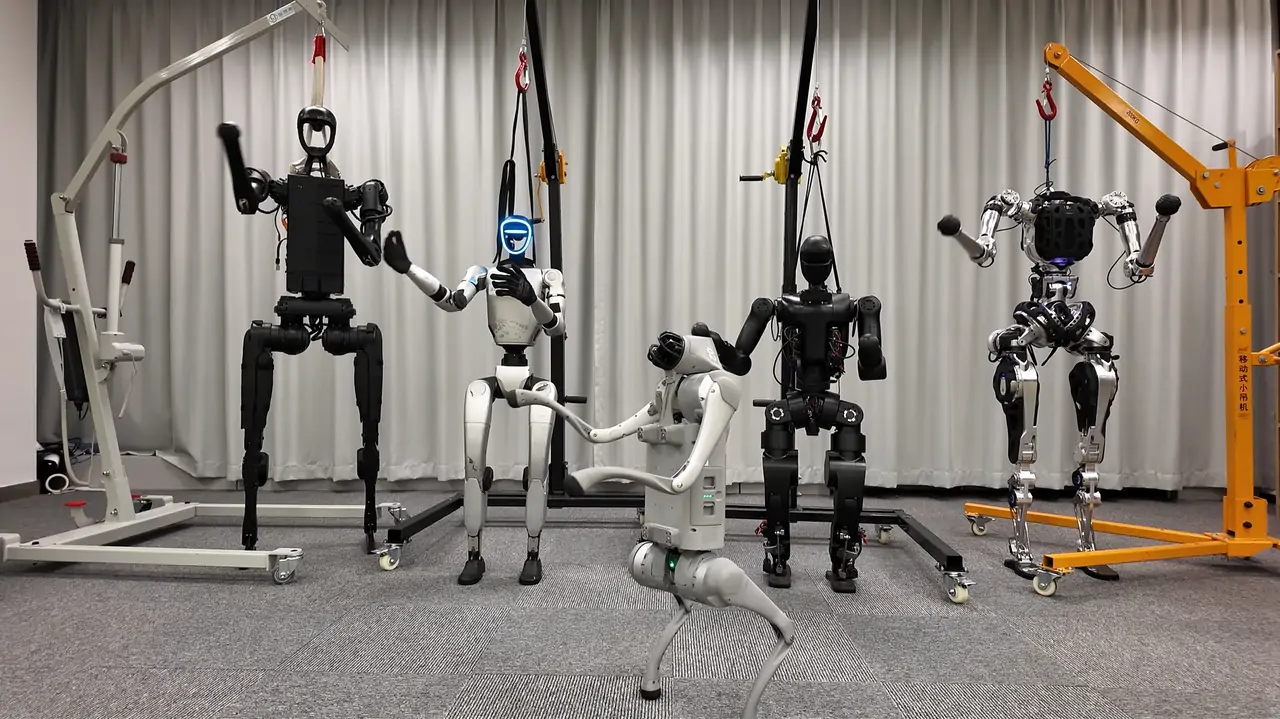

InternVLA-A1一脑多形、虚实贯通的理解、想象、执行一体化模型,赋能高动态场景的多机协作

人形运动智能

Humanoid Locomotion & Control Model

以人形机器人基础运动控制为起点,构建分层次、系统化的控制算法体系。融合多模态感知与深度强化学习技术,赋予控制策略本体泛化,技能泛化,环境泛化的能力。逐步实现从“基础运动”到“全身控制”再到“移动操作”的技能跃迁,显著增强机器人在复杂真实场景下的运动,指令跟随与精密操控能力

其他更多

More